Un’inchiesta pubblicata oggi dal New York Times rivela come Israele abbia trasformato il campo di battaglia in un laboratorio sperimentale senza precedenti per l’intelligenza artificiale applicata alla guerra. Un laboratorio in tempo reale, con esseri umani, spesso civili.

Secondo il quotidiano statunitense, citando interviste condotte con nove funzionari israeliani e americani della difesa, Israele ha impiegato la sua offensiva per testare e implementare rapidamente tecnologie militari basate sull’intelligenza artificiale, raggiungendo livelli mai visti prima. Droni capaci di inseguire autonomamente bersagli, software di riconoscimento facciale distribuiti ai checkpoint, chatbot che analizzano conversazioni in arabo.

Gran parte di questi sistemi sono il frutto di una collaborazione tra l’Unità 8200 – l’intelligence militare israeliana – e riservisti che lavorano in aziende di punta come Google, Microsoft e Meta. All’interno di un centro chiamato The Studio, questi esperti civili si sono ritrovati a progettare sistemi di guerra computazionale capaci di processare masse di dati in tempo reale. Un “Silicon Wadi” in uniforme, dove la logica del venture capital incontra quella dell’azione militare.

“Dopo il 7 ottobre – riferisce il New York Times – molte di queste tecnologie sono state autorizzate ed estese con una rapidità inusuale”. Tra gli strumenti in piena operatività spicca il “Lavender”, un algoritmo di apprendimento automatico sviluppato prima del conflitto per identificare presunti “terroristi” attraverso un’analisi incrociata di dati biometrici, sociali e digitali. Sebbene i suoi margini d’errore siano documentati, l’esercito israeliano lo ha comunque impiegato nelle prime fasi della guerra per selezionare obiettivi di attacchi aerei.

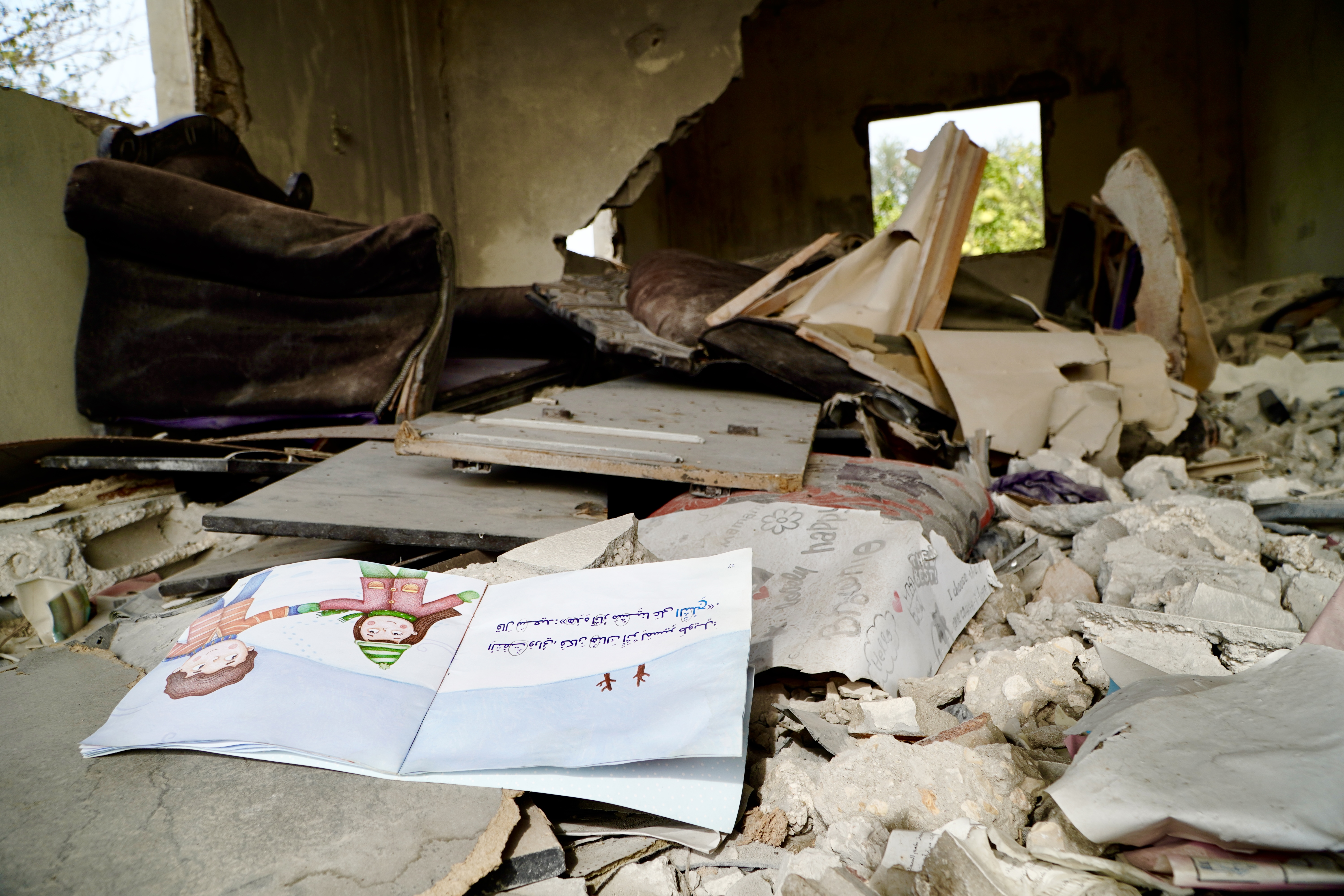

Il costo umano, come era prevedibile, è stato pesantissimo. Funzionari israeliani e americani hanno ammesso che l’uso di questi strumenti ha condotto a numerosi casi di identificazioni errate, arresti immotivati e, soprattutto, alla morte di civili. “Nessun’altra nazione ha sperimentato l’intelligenza artificiale sul campo con la stessa intensità e frequenza di Israele,” hanno affermato esperti militari europei e statunitensi. Il rischio, ora, è che quanto accaduto a Gaza diventi il modello delle guerre future.

Un elemento chiave dell’apparato è l’utilizzo del riconoscimento facciale, attuato soprattutto nei checkpoint temporanei. Qui, telecamere ad alta risoluzione inviano le immagini dei volti palestinesi a un sistema che, pur supportato dall’intelligenza artificiale, ha faticato a identificare correttamente persone con volti parzialmente oscurati o feriti. Gli errori, in ogni caso, non hanno fermato gli interrogatori e le detenzioni arbitrarie.

Non è tutto. L’Unità 8200 ha anche addestrato un large language model – un modello linguistico avanzato in lingua araba – servendosi di decenni di intercettazioni, trascrizioni e contenuti social rubati ai palestinesi. Il modello ha permesso di sviluppare un chatbot in grado di eseguire ricerche mirate tra conversazioni digitali, immagini e video. È un sistema che supera le barriere dei dialetti, tradizionalmente ostacolo per gli sviluppatori.

Le grandi aziende del tech coinvolte mantengono una posizione ambigua. Microsoft e Meta hanno rifiutato di commentare. Google dichiara che “il lavoro dei riservisti alle sue dipendenze non è collegato all’azienda”. Tuttavia, secondo Avi Hasson, amministratore delegato di Startup Nation Central, i dipendenti di queste compagnie hanno giocato un ruolo chiave nell’innovazione legata a droni e integrazione di dati, offrendo accesso a tecnologie che l’esercito israeliano da solo non possedeva.

Il caso più emblematico riguarda i droni autonomi sviluppati da XTEND, azienda israeliana che collabora con le Forze di Difesa. Il fondatore, Aviv Shapira, ha dichiarato che l’IA consente ora ai droni di identificare e inseguire oggetti in movimento – “un’auto o una persona” – con “precisione letale”. Un salto qualitativo che affranca i dispositivi dalla necessità di immagini statiche e che apre scenari di attacco automatizzato da remoto.

L’intera strategia non è nuova per Israele. Già nei conflitti precedenti a Gaza e in Libano, Tel Aviv aveva utilizzato le operazioni militari per mettere alla prova droni, spyware e il sistema di difesa Iron Dome. Ma questa volta la sofisticazione delle tecnologie impiegate segnano un salto epocale. E dietro la narrazione dell’”efficienza” e della “deterrenza”, si nasconde la fine di qualsiasi protezione per i civili innocenti.

Secondo il New York Times, alcuni ufficiali israeliani hanno sollevato timori etici riguardo all’uso eccessivo dell’IA. Ma le voci critiche restano minoritarie. Intanto, il “laboratorio di Gaza” continua a fornire dati, statistiche, esperimenti.